De twijfelende KI

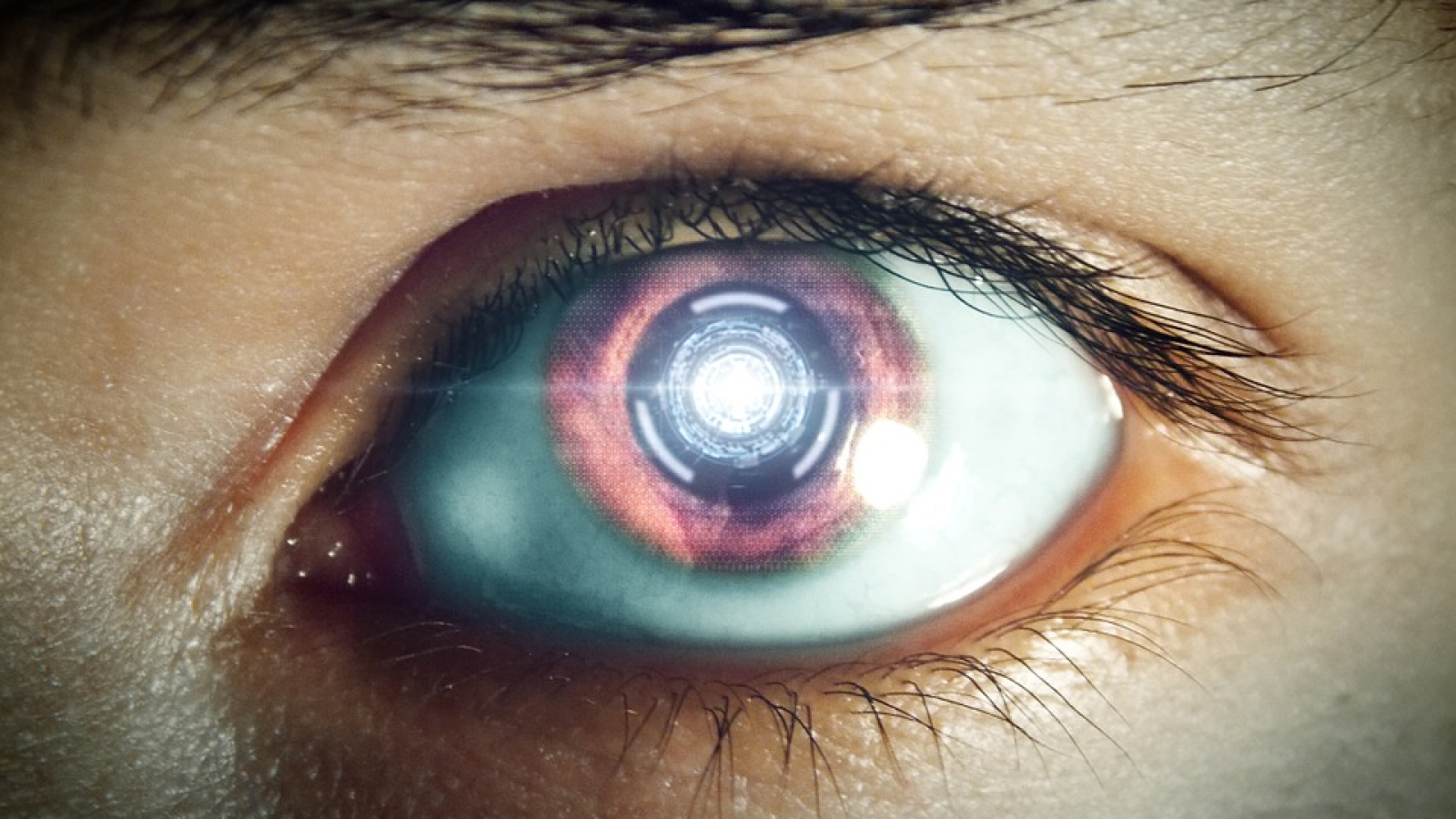

Kunstmatige intelligentie die beelden kan herkennen maakt ons dagelijks leven een stukje makkelijker. We vertrouwen erop dat Google Maps ons naar de juiste bestemming leidt, en dat de sensor in onze auto voorkomt dat we tegen een paal aanrijden. Telefoons met gezichtsherkenning zijn vrij normaal en voor de beveiliging van gebouwen worden slimme camera's gebruikt. We geloven dat de technologie hierachter goed werkt. Vaak is dat ook zo. Maar uit recent onderzoek blijkt kunstmatige intelligentie helemaal niet zo goed is in het herkennen van beelden als we vaak denken.

In dit onderzoek gaven de auteurs KI de taak om voorwerpen in een virtuele kamer te herkennen. Het presteerde goed, maar op het moment dat er onverwacht een vreemd object in beeld kwam, zoals een letterlijke elephant in the room, begint het fouten te maken in het herkennen van de objecten dat het eerder wel kon classificeren. Het slagingspercentage werd een stuk lager. Door het introduceren van een onverwacht object - de olifant - was het ineens niet meer in staat om taken uit te voeren die het eerder wél succesvol kon.

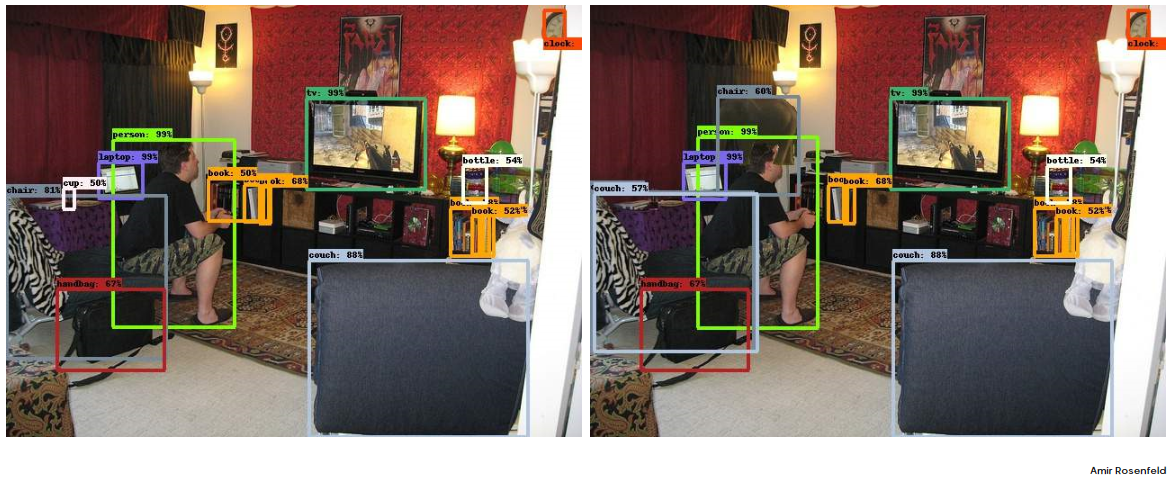

Links zie je de eerste situatie, waar de KI bijna alle objecten correct herkende. Rechts zie je exact dezelfde situatie, maar dan met een plaatje van een olifant eraan toegevoegd. Nu herkent de KI twee boekenstapels ineens niet meer, die het eerst wel herkende.

Volgens computerwetenschapper en filosoof Prof Mehdi Dastani gaat kunstmatige intelligentie op een andere manier om met onzekerheid dan mensen. Mensen zijn gewend aan onzekere situaties en hebben in de meeste gevallen geen moeite te denken in termen van waarschijnlijkheden. Dit helpt ons in het nemen van beslissingen. Het is niet heel waarschijnlijk dat je huis ineens in de brand vliegt wanneer je eten staat te maken, maar als de pan vlam vat en de gordijnen in brand vliegen heeft het afmaken van je gerecht geen prioriteit meer. Je moet jezelf in veiligheid brengen. Emoties spelen hierbij een cruciale rol. Brand leidt tot angst en angst leidt tot actie.

En dat is nou precies wat ontbreekt aan KI. KI voelt geen angst, blijdschap of teleurstelling. In plaats van een stap terug te nemen als een KI-systeem niet slaagt in het behalen van een taak, voelt het er niets bij en blijft onverstoord doorgaan. Dastani: "When a goal cannot be reached, the system will pointlessly keep trying until the power supply is drained". Een KI-systeem blijft vrolijk door koken, ook al staat alles om het heen in lichterlaaie. Dit zou kunnen verklaren waarom de KI in het onderzoek bepaalde objecten ineens niet meer kon herkennen: het bleef maar proberen te snappen wat die olifant in de kamer deed, en voelde geen verwarring of twijfel wat het motiveerde om de input opnieuw te bekijken.

De werking en functie van onzekerheid en emoties bij mensen kan model staan bij het programmeren van KI. Dastani stelt dat wanneer we een meer 'menselijke' reactie inprogrammeren, KI zich bij afwijkende informatie kan realiseren dat een bepaald doel niet gehaald kan worden. Op deze manier zou een iets 'menselijkere' manier van redeneren bij KI tot meer succes kunnen leiden en tot minder fouten.

Meer weten over twijfel en kunstmatige intelligentie? Kijk dan de lezing "A different state of mind" van Prof Mehdi Dastani terug.