Kunnen we algoritmes maken die niet uitsluiten?

De Nederlandse overheid verzamelt grote hoeveelheden privacygevoelige data van en over burgers. Wat er vervolgens met deze gegevens gebeurt is niet altijd zichtbaar, maar kan wel grote impact hebben op ons leven. Wanneer ik inlog op de website van de Belastingdienst om belastingaangifte te doen, schrik ik van de hoeveelheid informatie die over mij in het systeem staat: de overheid weet beter wat ik dit jaar heb verdiend dan ikzelf.

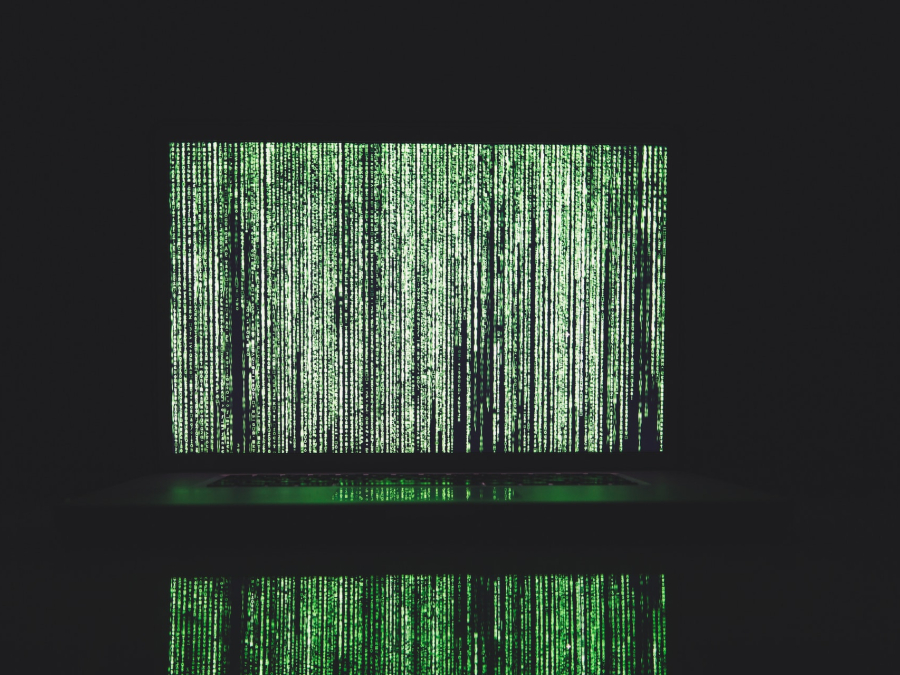

Algoritmen helpen overheidsinstanties omgaan met de oneindige stroom aan binnenkomende data. Deze computerprogramma's bepalen vervolgens op basis van jouw gegevens of jij bijvoorbeeld in aanmerking komt voor een steekproef, waarmee ze checken of je wel genoeg belasting betaalt of wel recht hebt op huurtoeslag. Heel efficiënt, maar hieraan kleeft ook een keerzijde: algoritmes die gebruikt worden om informatie te sorteren en verwerken zijn niet neutraal en kunnen discrimineren. Of jij dus wordt uitgekozen voor een steekproef, kan zomaar worden bepaald op basis van je naam of de buurt waarin je woont.

Discriminerende technologie

Cultuur- en mediawetenschapper dr. Gerwin van Schie (UU) onderzoekt hoe het gebruik van data en algoritmen kan leiden tot discriminatie en onrechtvaardigheid in Nederland. "Als je wordt geboren in Nederland, melden je ouders je aan bij de gemeente en komen je gegevens terecht in de databases van de overheid. Je leeftijd wordt geregistreerd, maar bijvoorbeeld ook je geboorteland én het geboorteland van je ouders."

Waarom is dit problematisch? Een voorbeeld dat dit illustreert is de Leefbarometer: een online tool van het ministerie voor Binnenlandse Zaken die voorspelde in hoeverre een buurt 'leefbaar' was. Persoonsgegevens over geboorteland werden gebruikt als meetinstrument voor kwaliteit en veranderden zo in een voorspeller voor de leefbaarheidsscore. Wanneer er in een wijk dus veel mensen woonden met ouders die in het buitenland geboren zijn, werd die wijk als minder 'leefbaar' bestempeld. Pas sinds begin 2022 is het CBS overgegaan op een nieuwe indeling, waarin minder bepalend is waar iemands ouders vandaan komen, en meer bepalend waar iemand zélf geboren is. Dit betekent dus dat overheidsinstanties nog steeds data over je achtergrond kunnen gebruiken om een onderscheid te maken tussen groepen mensen, buurten of steden.

Datadialoog

Data-discriminatie komt niet voort uit racistische overheidsmedewerkers die meer ongelijkheid willen creëren of bepaalde bevolkingsgroepen het leven zuur willen maken. Het is het gevolg van een manier van denken die sterk is verweven met de Nederlandse cultuur. Volgens Van Schie speelt cultuur een grote rol in het bepalen waar we data over verzamelen en waar niet. "Als je wil weten wat de etnische samenstelling van de gevangenispopulatie in Nederland is, kun je naar het CBS en vind je het zo. Maar als je iets wil weten over de diversiteit in hoogleraren in Nederland, zijn daar geen gegevens over." Systemen als de Leefbarometer zijn dus niet neutraal of objectief, omdat mensen met een bepaalde culturele blik zélf de categorieën in zo'n systeem bedenken. Het afnemen van een culturele bril gaat niet vanzelf, maar vergt aandacht.

Hoe lossen we dit op? Hoogleraar Inlichtingen en Recht prof. mr. Jan-Jaap Oerlemans (UU) pleit voor meer dialoog en openheid over de manier waarop overheidsinstanties met gegevens omgaan. Hij ziet dat steeds meer overheidsinstanties gegevens over burgers verzamelen. Maar hoe ver mogen ze hierin gaan? "Deze vraag wordt vaak niet genoeg publiekelijk besproken. Dat moeten we wél doen," zegt Oerlemans. Hij legt uit dat er te weinig toezicht is en dat adequate wetgeving eigenlijk nog ontbreekt. Hierdoor kunnen overheidsinstanties te ver gaan bij het verzamelen van inlichtingen en is het soms bijvoorbeeld niet duidelijk wat er met niet-gebruikte gegevens gebeurt.

Ook ethicus mr. dr. Bart Wernaart benadrukt het belang van het voeren van het gesprek over de datahonger van overheidsinstanties. Hij legt uit dat datatechnologie een prominentere plek op de publieke agenda nodig heeft. Er bestaat namelijk een zogenaamd democratisch deficit als het hierom gaat: "Technologie speelt nauwelijks een rol in de verkiezingen en de politiek, terwijl het een grote rol speelt in ons leven." Om dit probleem aan te pakken en te kunnen bepalen wat overheidsinstanties wel en niet mogen doen met persoonsgegevens, moet er volgens Wernaart eerst iets gebeuren met de gevoelens in de samenleving. "Je kunt niet wachten tot de wetgeving er iets mee doet: dan ben je te laat."