Kunstmatige intelligentie confronteert ons met eigen tekortkomingen

Google Translate, de noise cancelling in Teams-meetings en grappige verouderingsfilters op je telefoon. Dit zijn voorbeelden van kunstmatige intelligentie. De meeste toepassingen zijn zo ingebed in ons dagelijks leven dat we eraan voorbij gaan dat het geen mensenwerk is. Pas als het goed fout gaat staan we er bij stil. Denk maar terug aan de seksistische sollicitatierobot van Amazon, of die keer dat een Google Photos een gekleurde vrouw als 'gorilla' bestempelde. Opeens wordt duidelijk dat zelflerende systemen die hier gebruikt worden niet vlekkeloos zijn. Sterker nog, ze zijn soms discriminerend, racistisch of seksistisch. Dat klinkt bijna… menselijk?

Deze schadelijke toepassingen van kunstmatige intelligentie willen experts vermijden en als dat niet lukt, corrigeren. Maar hoe dan? Dr. Dieuwke Hupkes (FAIR Paris) legt uit wat de voor en nadelen van zelflerende systemen zijn, en ook hoe we ze kunnen gebruiken om menselijke intelligentie zelf beter te begrijpen. In haar eigen onderzoek richt ze zich op taalmodellen, maar de principes zijn toepasbaar op meerdere vlakken.

VAN SIMPEL NAAR COMPLEX

Het basisprincipe van zelflerende modellen is best simpel. Neem een taalmodel, die leert door teksten te lezen. Héél veel teksten, want "hoe meer tekst, hoe beter het model," aldus Hupkes. Denk aan Wikipedia, digitale kranten of boeken, tweets of speeches van politici. Praktisch het hele internet dus. Na het leren volgt het trainen van het model, een proces van trail and error. Naderhand kan het model niet alleen niet alleen teksten genereren, maar ook gerichte vragen beantwoorden. Het kent creativiteit, grammatica én logica. Meestal, in ieder geval.

"I am not a human. I am a robot (…) I taught myself everything that I know just by reading the internet, and now I can write this column."

- Taalmodel GPT-3, september 2020 in The Guardian

De ontwikkeling van zelflerende modellen is de afgelopen jaren flink versneld door de enorme technologische voortuitgang. Decennia geleden begon het met het n-gram model. Dit model is gebaseerd op vaste woordcombinaties en kansberekeningen. Stel, een zin begint met: "een heleboel mensen…". Gebaseerd op alle teksten die het model heeft gelezen, kiest het model het meest voorkomende woord en plakt dit achter de vorige woorden. De simpele versie zul je nog wel kennen van de T-9 op je oude Nokia. Deze stappen herhalen zich, totdat er een hele zin staat. Best simpel dus, maar het werkt verassend goed. Het is alleen bij lange na niet geavanceerd genoeg om de toenemende vraag van ons mensen bij te benen.

DE 'BLACK BOX' VAN ZELFLERENDE MODELLEN

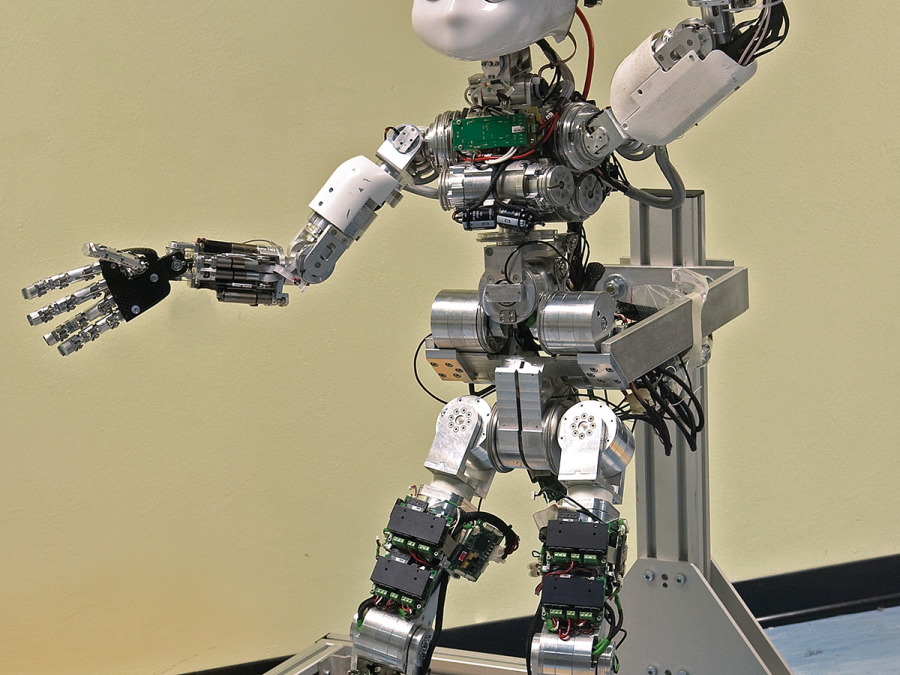

U vraagt, wij draaien en dus werd er een nieuw model ontwikkeld: een neuraal netwerk. Met de komst van dit model ontstond er een wereld aan mogelijkheden voor zelflerende systemen in de samenleving. Denk aan AutoTune, automatische ondertiteling of chatbots. De belangrijkste verandering? Neurale netwerken laten vaste woordcombinaties los en kijken juist naar de context van de woorden.

Je kan een neuraal netwerk het beste vergelijken met het brein. Net als onze hersenen zijn de neurale netwerken opgebouwd uit individuele neuronen. Deze kunstmatige neuronen communiceren onderling met elkaar en op basis van deze communicatie kan het model voorspellingen doen. De nieuwste vorm van neurale netwerken, attentie netwerken, neemt ook eerder gebruikte versies van woordcombinaties mee in zijn beslissing. Het kan dus terug in de tijd. Hiermee overstijgt het attentie netwerk zelfs de werking van de menselijke hersenen.

Enorm fascinerend, maar ook een beetje beangstigend. Want hoe het model nou precies tot zijn uiteindelijke beslissing komt, weten ook de experts nog niet helemaal. Het is een zogenoemde black box. Maar is het echt zo erg dat we niet precies weten hoe het werkt? Hoewel we als mens intuïtief graag willen weten hoe en wat, is juist die onwetendheid ook de kracht van zelflerende modellen. Hupkes: "dit is waarom ze zo goed werken. Modellen worden niet beperkt door ons, ze kunnen hun eigen oplossingen vinden. Wij zeggen wat ze moeten doen. En zij mogen zelf weten hoe." Er is een vrij nieuw vakgebied dat gericht is op explainable en interpretable A.I, dat van de black box een transparante box wil maken.

SPIEGEL VAN ONSZELF

Hupkes weet natuurlijk ook wel dat de onvoorspelbaarheid van zelflerende modellen risico's met zich meebrengt. Modellen kunnen onverwachte fouten maken. Of ze zijn bevoordeeld en maken hun beslissingen op basis van discriminerende of seksistische overtuigingen. Wat doen we hieraan? Soms is het simpel. De seksistische sollicitatietool van Amazon? Gewoon niet meer gebruiken. Veel vaker is het ontzettend lastig. Want wat als een goed functionerend detectiesysteem voor kanker beter werkt voor witte dan voor gekleurde mensen? Moet dat dan uitgezet worden? Het is een ethisch vraagstuk.

Wanneer we wat dieper kijken naar de reden waarom het detectiesysteem beter werkt voor witte mensen, komen we tot een confronterende realisatie. Zelflerende modellen zijn namelijk puur gebaseerd op datgene dat wij ze voeren. Onze teksten, onze bewuste en onbewuste vooroordelen. De trainingsdata voor het detectiemodel bestaat onder andere uit clinical trials, die onderzoeken includeren bijna uitsluitend witte jonge mannen. Daar is vaak kritiek op en blijkt nu ook weer ongewenst. Maar als het model een directe weerspiegeling is van ons eigen denken en doen, ligt de fout dan bij het model of bij onszelf?

VOLGENDE WEEK IN 'THE BIGGER PICTURE'

In de volgende lezing in deze serie kijkt epidemiologe dr. Virissa Lenters (UU) met een kritische blik naar onze gezondheid. Want hoewel we onze voeding en hygiëne aanzienlijk hebben verbeterd, leven we daadwerkelijk gezonder? En wat maakt ons nu nog ziek?

Heb je nu al een vraag voor Virissa? Mail ons op info[at]sg.uu.nl, waarbij je '[at]' vervangt door '@'. We zullen je vraag proberen te bespreken met onze gast.